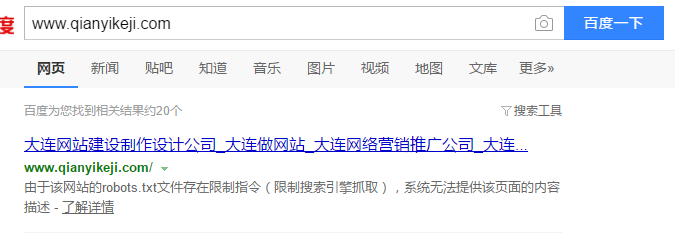

www.qianyikeji.com 之前网站在上线添加完善内容的时候设置了robots屏蔽搜索引擎抓取,中间可能持续了有2周左右的时间,现在网站资料已经添加完善,解除了robots屏蔽;但在百度搜索网址,仍然显示“由于该网站的robots.txt文件存在限制指令(限制搜索引擎抓取),系统无法提供该页面的内容描述 - 了解详情”,这边已经向百度提交了网址 sitemap地图等 但是现在一个多月过去了 还是没有解除。

通过以上我百度了好多资料 原来不是马上能解除的一般要在2个月左右才能解除。

如果网友遇到这样的情况一般你解除限制2个月内会恢复正常,原因是:首先要理解的就是robotx.txt是一个搜索引擎抓取协议而非指令,你解除但是在搜索引擎方面是有记录的,所以不可能解除之后立即生效而是有延迟生效的情况。

在大连网站制作公司小编慎重的提醒各位朋友,新建的网站,千万不要先把网站文件上传到空间后加个robots.txt,然后填充信息,填充好了才开放抓取。如果可以在本地把网站建好,填充好内容再上传最好,否则上传到空间加robots禁止抓取,等开放抓取的时候,百度蜘蛛很可能又会几个月时间都反应不过来。几个月后网站才被收录,对网站优化的周期影响无疑是巨大的。